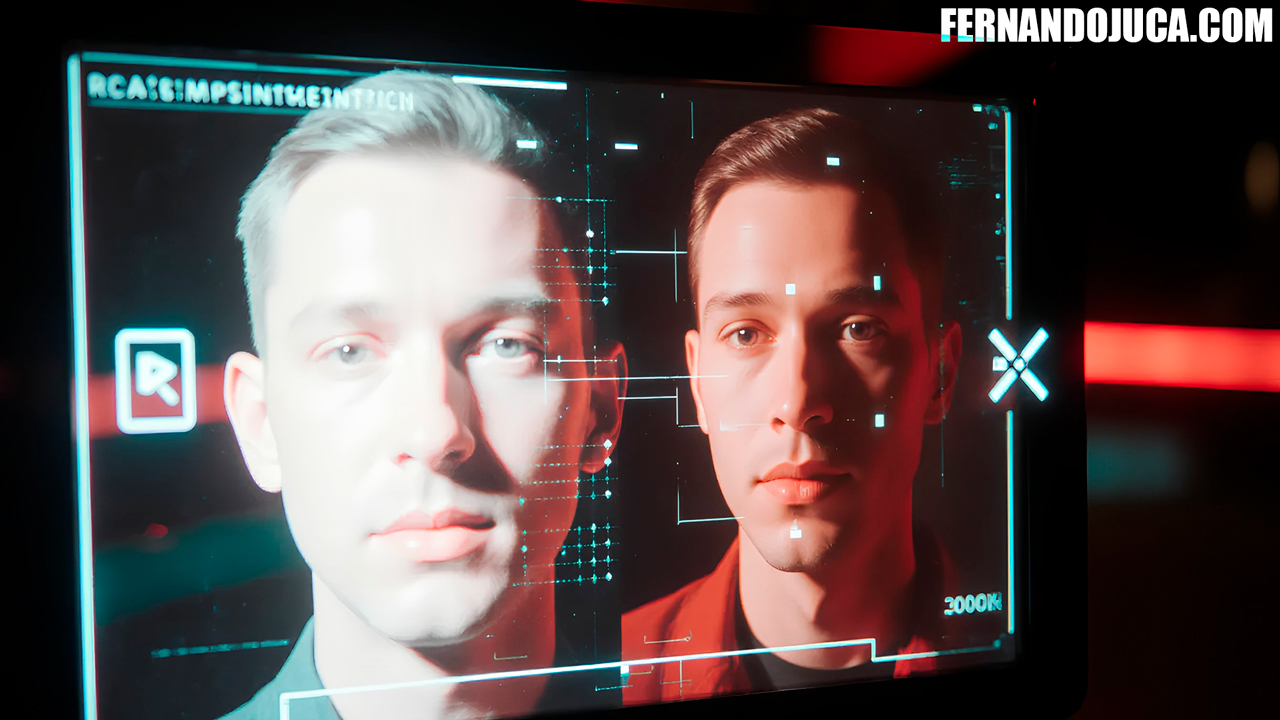

🧠 Una nueva amenaza: los deepfakes y la crisis de la confianza digital

Los deepfakes se han convertido en uno de los fenómenos más disruptivos del entorno digital.

Gracias a modelos de inteligencia artificial capaces de replicar rostros y voces con precisión casi perfecta, la línea entre lo real y lo manipulado se ha difuminado.

El impacto es especialmente preocupante para figuras públicas, periodistas o creadores de contenido, cuyas imágenes son fácilmente accesibles y pueden ser reutilizadas para generar videos falsos con fines engañosos o maliciosos.

En este contexto, YouTube ha comenzado a probar una herramienta experimental llamada “likeness detection”, cuyo objetivo es ayudar a los creadores a detectar si su rostro aparece en videos generados por IA sin su consentimiento.

🔍 Cómo funciona la herramienta de detección de semejanza

La nueva función está integrada dentro de la sección Content Detection de YouTube Studio, y actualmente solo está disponible para un grupo limitado de creadores seleccionados.

Aquellos con acceso anticipado reciben una notificación por correo electrónico para activar la prueba.

Aunque Google no ha detallado el funcionamiento interno, se estima que la herramienta utiliza modelos de reconocimiento facial basados en IA que comparan videos subidos a la plataforma con una base de datos visual generada a partir del contenido del propio creador.

En la práctica, sería como tener un “espejo digital” que analiza constantemente los videos públicos en busca de rostros similares al del usuario.

El sistema identificaría coincidencias incluso si los videos han sido manipulados, editados o alterados con técnicas de deepfake.

🧩 Para que el sistema funcione correctamente, necesita una gran cantidad de material visual del creador, lo que limita su uso a quienes tienen una presencia consolidada en YouTube.

⚠️ Falsos positivos y desafíos de precisión

Como toda tecnología de detección basada en IA, likeness detection no está exenta de errores.

YouTube ha advertido que podrían producirse falsos positivos, es decir, que el sistema confunda videos auténticos o colaborativos con imitaciones.

Por ejemplo:

-

Un creador podría ser alertado de un deepfake cuando en realidad se trata de una colaboración legítima.

-

Los videos de reacción o entrevistas también podrían activar alertas erróneas.

Para evitar este problema, Google planea incluir filtros adicionales que permitan excluir ciertos tipos de videos de las búsquedas de semejanza.

El reto está en mantener el equilibrio entre sensibilidad y precisión, evitando que la herramienta se vuelva un “detector de humo” que suene ante cualquier mínima coincidencia.

🔒 Privacidad: el costo de proteger la identidad

Uno de los puntos más sensibles del proyecto es la privacidad de los creadores.

Para operar, el sistema necesita construir un modelo facial digital del usuario, lo que implica procesar y almacenar una gran cantidad de datos biométricos.

Esto plantea una pregunta clave:

¿Hasta qué punto estamos dispuestos a entregar una versión digital de nuestro rostro para protegernos de los deepfakes?

El dilema es real. Para muchos, se trata de un sacrificio aceptable si garantiza la defensa de su reputación y la prevención de suplantaciones.

Sin embargo, otros temen que esta información pueda ser usada con otros fines o comprometer la privacidad personal.

🧩 Un paso necesario frente al abuso de la IA

La iniciativa de YouTube llega en un momento crucial.

La misma tecnología que permitió la creación de herramientas generativas como Gemini, Sora o Veo 3.1 está ahora dando lugar a abusos que erosionan la confianza pública en el contenido digital.

El lanzamiento de likeness detection representa un intento de autorregulación tecnológica, donde la plataforma busca mitigar los riesgos de las herramientas que ella misma ayudó a popularizar.

🧭 En otras palabras, YouTube reconoce que la innovación sin control requiere frenos: crear, pero también proteger.

Aunque el programa está en fase beta, podría sentar las bases para una nueva generación de herramientas de autenticidad digital, no solo en YouTube, sino en todo el ecosistema de redes sociales y plataformas de video.

🛡️ Una herramienta con potencial ético y social

Más allá del aspecto técnico, esta medida tiene implicaciones sociales y éticas profundas.

Permitir que los creadores controlen el uso de su imagen refuerza el derecho a la identidad digital, un tema cada vez más relevante en la era de la IA generativa.

Para los creadores con mayor visibilidad, esta tecnología podría convertirse en una pieza esencial de su seguridad digital, al mismo nivel que la verificación de identidad o la protección de copyright.

Y para el público general, es una señal de que las plataformas comienzan a asumir su responsabilidad frente a la manipulación masiva de contenido audiovisual.

🌍 Un primer paso en una batalla más grande

La detección de semejanza no resolverá por sí sola el problema de los deepfakes, pero marca un punto de inflexión en la lucha contra la desinformación visual.

Con el tiempo, este tipo de sistemas podría complementarse con marcadores digitales de autenticidad (watermarks), blockchain de identidad o verificaciones cruzadas entre plataformas.

En un entorno donde las falsificaciones audiovisuales se multiplican, la defensa de la verdad digital dependerá tanto de las herramientas como de la conciencia del usuario.

Y en ese frente, YouTube acaba de dar un paso importante.